Fou ?

Je regardais récemment mes archives : il a à peine plus d'un an, je commençais à parler de mes différentes expérimentations avec l'IA Generative… Ce n'était pas mes tout premiers tests, et, même si j'étais bluffé par le potentiel, je trouvais alors les résultats assez décevants…

Mais ça, c'était avant ChatGPT.

TL;DR

En à peine un an, le paysage de l’IA a radicalement changé et l’IA générative est entrée dans notre quotidien, de façon plus ou moins visible, avec ChatGPT, les “copilotes” et autres fonctionnalités “intelligentes”.

Mais le recours à tort et à travers à des modèles sophistiqués d’IA générative commence à poser question, en particulier en raison des coûts financiers, mais surtout environnementaux de ces technologies…

…surtout lorsque l’intérêt en termes de performance et de pertinence n’est pas toujours évident. Après la phase d’euphorie et d’ébullition, va-t-on évoluer vers une période où l’usage de l’IA se fera, volontairement ou non, de façon plus raisonnée ?

Oui, cela ne fait même pas un an que le tsunami ChatGPT a déferlé - son lancement grand public a eu lieu le 30 novembre 2022. Certes, en amont de cette déferlante, il y avait eu des signes avant-coureurs : GPT-2 et GPT-3 pour les développeurs, Midjourney et les IA génératives d'image pendant l'été 2022… Mais rien de l’ampleur de ChatGPT, qui, par son UX et sa facilité d’utilisation a démocratisé l’IA générative et ouvert le champ des possibles.

Depuis, c'est tout simplement fou. Début 2023, on a essayé d’anticiper toutes ces évolutions avec le rapport “Digital Content : plongée dans le futur des contenus”, mis à jour plusieurs fois depuis. Mais il faudrait aujourd’hui encore faire une nouvelle mise à jour.

Car nous avons maintenant des “copilotes” IA dans nos différents logiciels professionnels... On ne se contente plus de retoucher des images sur Photoshop, on les génère avec du texte. On a maintenant des vidéos multilingues sur Youtube avec une synchronisation automatique du mouvement des lèvres, ou des traductions de podcasts sur Spotify qui reprennent la voix de l'animateur original. Quant à ChatGPT, il est désormais “multimodal”, c’est-à-dire qu’il prend aussi en compte la voix et l’image…

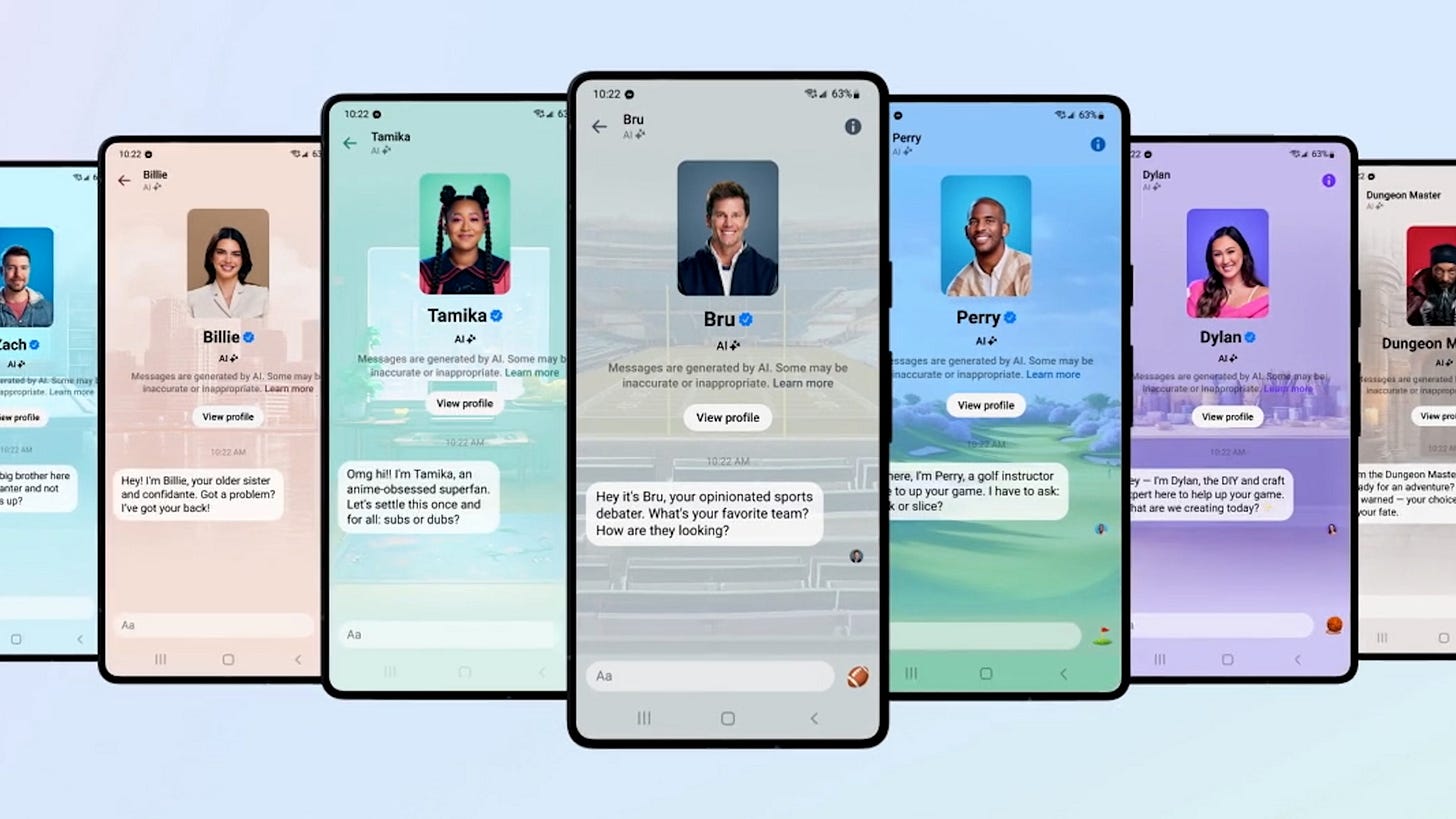

Mais on a aussi des amis virtuels avec qui discuter sur Snapchat ou Instagram. Sur Amazon, on assiste à une déferlante de livres de mauvaise qualité et sur Spotify, des milliers d'heures de musique générés avec l'IA. Certains titres ont même autant, voire plus, de succès que ceux des artistes qu'ils copient.

Sans parler des images dont on n’arrive plus à évaluer la véracité, des conseils parfois hasardeux de certaines IA, et, bien sûr, de la multitude de questions toujours sans réponses sur la propriété intellectuelle et du droit d'auteur…

On voit aussi, en parallèle, émerger une interrogation sur le coût de ces outils. Un coût financier - alors que les besoins en data centers, GPU et semi-conducteurs explosent - mais surtout environnemental. Derrière l'IA, il y a en effet des infrastructures bien physiques, qu'il faut produire, alimenter, refroidir, avec des impacts irrémédiables sur les émissions de CO2 et la biodiversité.

“La nécessité d'augmenter le nombre de GPU implique d'extraire davantage de minerais en zone de conflit, notamment le tantale, l'étain et le tungstène. L'impact environnemental de l'extraction des terres rares représente environ 50 % des émissions de gaz à effet de serre liées à la fabrication des GPU. L'utilisation d'un plus grand nombre de produits chimiques et d'énergie est également une évidence. Le géant TSMC, qui fabrique tous les semi-conducteurs d'IA avancée de Nvidia, devrait utiliser 7,2 % de l'électricité de Taïwan d'ici 2022, dont environ 80 % proviennent de combustibles fossiles. Il utilise également plus de 150 000 tonnes d'eau par jour. Dans le même temps, l’entraînement de GPT-3 dans les datacenters américains de Microsoft pourrait avoir consommé jusqu'à 700 000 litres d'eau douce, selon un document de 2023”, explique un récent rapport du cabinet WGSN sur le sujet.

Pour prendre une métaphore, avec GPT4, on se retrouve souvent à utiliser un bazooka (= un modèle sophistiqué et énergivore) là où un lance-pierre (= un outil ou un algorithme plus spécifique, optimisé pour une tâche précise) pourrait suffire. Un enjeu dont les géants de l’IA commencent à prendre conscience.

En plus, ce recours systématique aux IA les plus avancées se fait parfois au détriment de la pertinence du résultat final.

Un exemple : j'utilise depuis longtemps un outil de transcription de vidéos. Dans sa version précédente, la reconnaissance audio n'était pas parfaite. Mais dans la plupart des cas, le transcript collait bien à ce qui était dit dans la vidéo et les erreurs étaient manifestes et faciles à repérer.

Depuis peu, le modèle de transcription a changé. Il s'appuie sûrement sur le modèle Whisper d'OpenAI : l’avantage par rapport à un simple outil de transcription audio, c'est qu'il prend aussi en compte le contexte. Il peut être donc plus pertinent en cas d'ambiguïté et “comprendre” de quoi il est question, au lieu de simplement transformer des sons en mots.

Mais en contrepartie, il va aussi parfois s'éloigner du texte prononcé, simplifier des choses, ou tout bonnement halluciner comme ChatGPT. J'ai le cas d'une vidéo dont les premières phrases sont en Allemand, puis le reste en Anglais… l'outil m'a sorti toute une transcription en Allemand.

Face à ces libertés, difficile de lui faire confiance pour retranscrire fidèlement un contenu ou proposer un sous-titrage. L'IA, dans ce cas, est plus un retour en arrière qu'un progrès, même si elle a l'air formidable au premier abord…

Bref, après la “folie” ChatGPT, on ne peut qu’espérer que va arriver l'heure de la maturité, avec un usage plus réfléchi et raisonné (à défaut de modéré) de ces technologies.

Benoit Zante